Fique informado com atualizações gratuitas

Basta se inscrever no Inteligência artificial MEFT Digest – entregue diretamente à sua caixa de entrada.

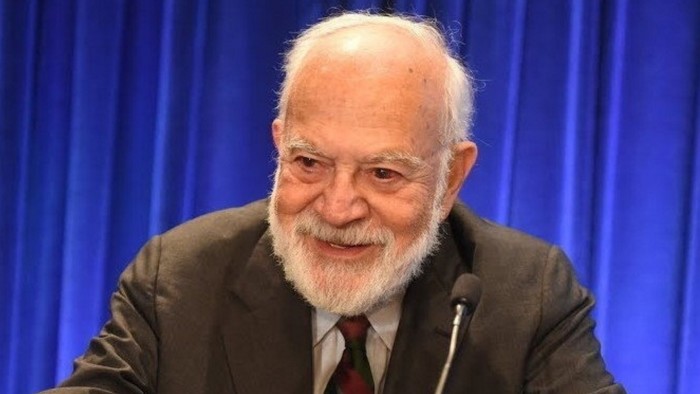

As mentiras não são o maior inimigo da verdade, de acordo com o filósofo Harry Frankfurt. Besteira é pior.

Como ele explicou em seu ensaio clássico Em besteira (1986), um mentiroso e um contador de verdade estão jogando o mesmo jogo, em lados opostos. Cada um responde aos fatos como os entende e aceita ou rejeita a autoridade da verdade. Mas um besteira ignora essas demandas completamente. “Ele não rejeita a autoridade da verdade, como o mentiroso, e se opõe a si mesmo. Ele não presta atenção a ela. Em virtude disso, besteira é um inimigo maior da verdade do que as mentiras.” Essa pessoa quer convencer os outros, independentemente dos fatos.

Infelizmente, Frankfurt morreu em 2023, apenas alguns meses após o lançamento do ChatGPT. Mas ler seu ensaio na era da inteligência artificial generativa provoca uma familiaridade enjoada. Em vários aspectos, o ensaio de Frankfurt descreve cuidadosamente a saída de modelos de idiomas grandes habilitados para AI. Eles não estão preocupados com a verdade porque não têm concepção disso. Eles operam por correlação estatística não observação empírica.

“A maior força deles, mas também o maior perigo, é a capacidade deles de parecer autorizada em praticamente qualquer tópico, independentemente da precisão factual. Em outras palavras, sua superpotência é sua capacidade sobre -humana de besteira”. Carl Bergstrom e Jevin West escreveram. Os dois professores da Universidade de Washington realizam um curso on -line – Oráculos modernos ou máquinas de besteira? – examinar esses modelos. Outros renomearam a saída das máquinas como Botshit.

Uma das características mais conhecidas e perturbadoras, mas, às vezes, interessantes, do LLMS, é sua “alucinação” de fatos-ou simplesmente inventar as coisas. Alguns pesquisadores argumentam que essa é uma característica inerente dos modelos probabilísticos, não um bug que pode ser corrigido. Mas as empresas de IA estão tentando resolver esse problema, melhorando a qualidade dos dados, ajustando seus modelos e construindo sistemas de verificação e verificação de fatos.

Eles pareceriam ter algum caminho a percorrer, considerando Um advogado da Antrópico disse a um tribunal californiano este mês que seu escritório de advocacia havia enviado involuntariamente uma citação incorreta alucinada pelo Claude da empresa de IA. Como sinalizadores de chatbot do Google para os usuários: “Gêmeos pode cometer erros, inclusive sobre pessoas, então verifique duas vezes”. Isso não impediu o Google desta semana, lançando um “modo AI” para todos os seus principais serviços nos EUA.

As maneiras pelas quais essas empresas estão tentando melhorar seus modelos, incluindo o aprendizado de reforço com o feedback humano, corre o risco de introduzir viés, distorção e julgamentos de valor não declarados. Como o FT mostrou, a IA Chatbots de Openai, Anthrópica, Google, Meta, Xai e Deepseek descrevem as qualidades dos executivos principais de suas próprias empresas e os de rivais de maneira muito diferente. O GROK de Elon Musk também promoveu memes sobre o “genocídio branco” na África do Sul em resposta a avisos totalmente não relacionados. Xai disse que corrigiu a falha, que culpou uma “modificação não autorizada”.

Tais modelos criam uma nova categoria ainda pior de danos em potencial – ou “discurso descuidado”, de acordo com Sandra Wachter, Brent Mittelstadt e Chris Russell, Em um artigo do Oxford Internet Institute. Na sua opinião, a fala descuidada pode causar danos intangíveis, de longo prazo e cumulativos. É como “besteira invisível” que deixa a sociedade idiota, Wachter me diz.

Pelo menos com um político ou vendedor, normalmente podemos entender sua motivação. Mas os chatbots não têm intencionalidade e são otimizados para a plausibilidade e o engajamento, não a veracidade. Eles inventarão fatos sem propósito. Eles podem poluir a base de conhecimento da humanidade de maneiras insondáveis.

A questão intrigante é se os modelos de IA podem ser projetados para maior veracidade. Haverá uma demanda de mercado por eles? Ou os desenvolvedores de modelos devem ser forçados a cumprir os padrões mais altos da verdade, conforme aplicar aos anunciantes, advogados e médicos, por exemplo? Wachter sugere que o desenvolvimento de modelos mais verdadeiros levaria tempo, dinheiro e recursos que as iterações atuais foram projetadas para economizar. “É como querer que um carro seja um avião. Você pode empurrar um carro de um penhasco, mas não vai desafiar a gravidade”, diz ela.

Tudo isso dito, os modelos generativos de IA ainda podem ser úteis e valiosos. Muitos negócios lucrativos – e políticas – carreiras foram construídas sobre besteiras. A IA generativa adequadamente usada pode ser implantada para inúmeros casos de uso comercial. Mas é ilusório e perigoso confundir esses modelos com máquinas da verdade.